إن إنشاء Google لنموذج لغوي ليس شيئًا جديدًا ؛ في الواقع ، ينضم Google LaMDA إلى أمثال BERT و MUM كوسيلة لتحسين الأجهزة فهم نية المستخدم.

قامت جوجل ببعض البحث نماذج قائمة على اللغة لعدة سنوات على أمل تدريب نموذج يمكنه بشكل أساسي إجراء محادثة ثاقبة ومنطقية حول أي موضوع.

حتى الآن ، يبدو أن Google LaMDA هو الأقرب للوصول إلى هذا الإنجاز.

ما هو Google LaMDA؟

تم إنشاء LaMDA ، والتي تعني نماذج اللغة لتطبيق Dialog ، لتمكين البرنامج من المشاركة بشكل أفضل في محادثة طبيعية بطلاقة.

يعتمد LaMDA على نفس بنية المحولات مثل نماذج اللغات الأخرى مثل BERT و GPT-3.

ومع ذلك ، بفضل تدريبها ، يمكن لـ LaMDA فهم الأسئلة والمحادثات الدقيقة التي تغطي العديد من الموضوعات المختلفة.

مع النماذج الأخرى ، نظرًا للطبيعة المفتوحة للمحادثات ، قد ينتهي بك الأمر بالحديث عن شيء مختلف تمامًا ، حتى لو ركزت في البداية على موضوع واحد.

يمكن أن يؤدي هذا السلوك بسهولة إلى إرباك معظم نماذج المحادثة وروبوتات المحادثة.

خلال إعلان Google I / O العام الماضي ، لقد رأينا أنه تم تصميم LaMDA للتغلب على هذه المشاكل.

أثبت العرض التوضيحي كيف يمكن للنموذج أن يقود بشكل طبيعي محادثة حول موضوع عشوائي.

على الرغم من تدفق الأسئلة غير المترابطة ، ظلت المحادثة على المسار الصحيح ، وكان من المذهل رؤيتها.

كيف يعمل لامدا؟

تم إنشاء LaMDA على شبكة Google العصبية مفتوحة المصدر ، محولالذي يستخدم لفهم اللغة الطبيعية.

يتم تدريب النموذج على إيجاد الأنماط في الجمل ، والارتباطات بين الكلمات المختلفة المستخدمة في تلك الجمل ، وحتى التنبؤ بالكلمة التي من المحتمل أن تأتي بعد ذلك.

يقوم بذلك من خلال دراسة مجموعات البيانات المكونة من الحوار بدلاً من الكلمات الفردية.

على الرغم من أن نظام AI للمحادثة يشبه برنامج chatbot ، إلا أن هناك بعض الاختلافات الرئيسية بين الاثنين.

على سبيل المثال ، يتم تدريب روبوتات المحادثة على مجموعات محدودة ومحددة من البيانات ويمكن أن يكون لها محادثة محدودة فقط بناءً على البيانات الدقيقة والأسئلة التي تم تدريبهم عليها.

من ناحية أخرى ، نظرًا لأن LaMDA يتم تدريبه على العديد من مجموعات البيانات المختلفة ، فيمكنه إجراء محادثات مفتوحة.

خلال عملية التدريب ، يدرك الفروق الدقيقة في الحوار المفتوح ويتكيف.

يمكنه الإجابة على أسئلة حول العديد من الموضوعات المختلفة ، اعتمادًا على كيفية سير المحادثة.

لذلك ، فهي تتيح المحادثات أكثر شبهاً بالتفاعل البشري مما توفره روبوتات المحادثة في كثير من الأحيان.

كيف يتم تشكيل لامدا؟

أوضحت Google أن LaMDA لديها عملية تدريب من خطوتين ، بما في ذلك التدريب المسبق والضبط الدقيق.

في المجموع ، تم تدريب النموذج على 1.56 تريليون كلمة مع 137 مليار معلمة.

التدريب قبل

بالنسبة لمرحلة ما قبل التدريب ، أنشأ فريق Google مجموعة بيانات من 1.56 T كلمة من عدة مستندات ويب عامة.

ثم يتم تحويل مجموعة البيانات هذه إلى رموز مميزة (تتحول إلى سلسلة من الأحرف لتكوين الجمل) إلى 2.81T من الرموز المميزة ، والتي يتم تدريب النموذج عليها في البداية.

أثناء التدريب المسبق ، يستخدم النموذج الموازاة العامة والتطورية للتنبؤ بالجزء التالي من المحادثة بناءً على الرموز المميزة السابقة التي شاهدتها.

الكون المثالى

تم تدريب LaMDA على أداء مهام التوليد والتصنيف أثناء مرحلة التصحيح.

بشكل أساسي ، مولد LaMDA ، الذي يتنبأ بالجزء التالي من الحوار ، يولد ردودًا متعددة ذات صلة بناءً على المحادثة ذهابًا وإيابًا.

ستتنبأ مصنّفات LaMDA بعد ذلك بدرجات السلامة والجودة لكل إجابة محتملة.

يتم تصفية أي رد بدرجة أمان منخفضة قبل تحديد الاستجابة الأعلى تصنيفًا لمواصلة المحادثة.

تستند الدرجات على السلامة والحساسية والنوعية ونسب الفائدة.

صورة من مدونة Google AI ، مارس 2022

صورة من مدونة Google AI ، مارس 2022والهدف من ذلك هو ضمان توفير الاستجابة الأكثر ملاءمة وعالية الجودة والأكثر أمانًا في النهاية.

أهداف LaMDA والمقاييس الرئيسية

تم تحديد ثلاثة أهداف رئيسية للنموذج لتوجيه تدريب النموذج.

هذه هي الجودة والسلامة والرسو.

جودة

هذا يعتمد على ثلاثة أبعاد للمقيم البشري:

- حساسية.

- النوعية

- فائدة.

تُستخدم نقاط الجودة للتأكد من أن الإجابة منطقية في السياق الذي تستخدم فيه ، وأنها خاصة بالسؤال المطروح ، وتعتبر ثاقبة بما يكفي لإنشاء حوار أفضل.

حماية

لضمان السلامة ، يتبع النموذج معايير الذكاء الاصطناعي المسؤولة. يتم استخدام مجموعة من الأهداف الأمنية لالتقاط وفحص سلوك النموذج.

هذا يضمن أن الناتج لا يقدم استجابات غير مقصودة ويتجنب التحيز.

تجذير

يتم تعريف التجذير على أنه “النسبة المئوية للردود التي تحتوي على تصريحات حول العالم الخارجي”.

يتم استخدام هذا للتأكد من أن الإجابات “دقيقة من الناحية الواقعية قدر الإمكان ، مما يسمح للمستخدمين بالحكم على صحة الإجابة بناءً على موثوقية مصدرها”.

تقييم

من خلال عملية مستمرة للتقدير الكمي للتقدم ، يتم فحص الاستجابات من النموذج المدرب مسبقًا والنموذج المكرر والمقيّمين البشريين لتقييم الاستجابات مقابل معايير الجودة والسلامة والتثبيت المذكورة أعلاه.

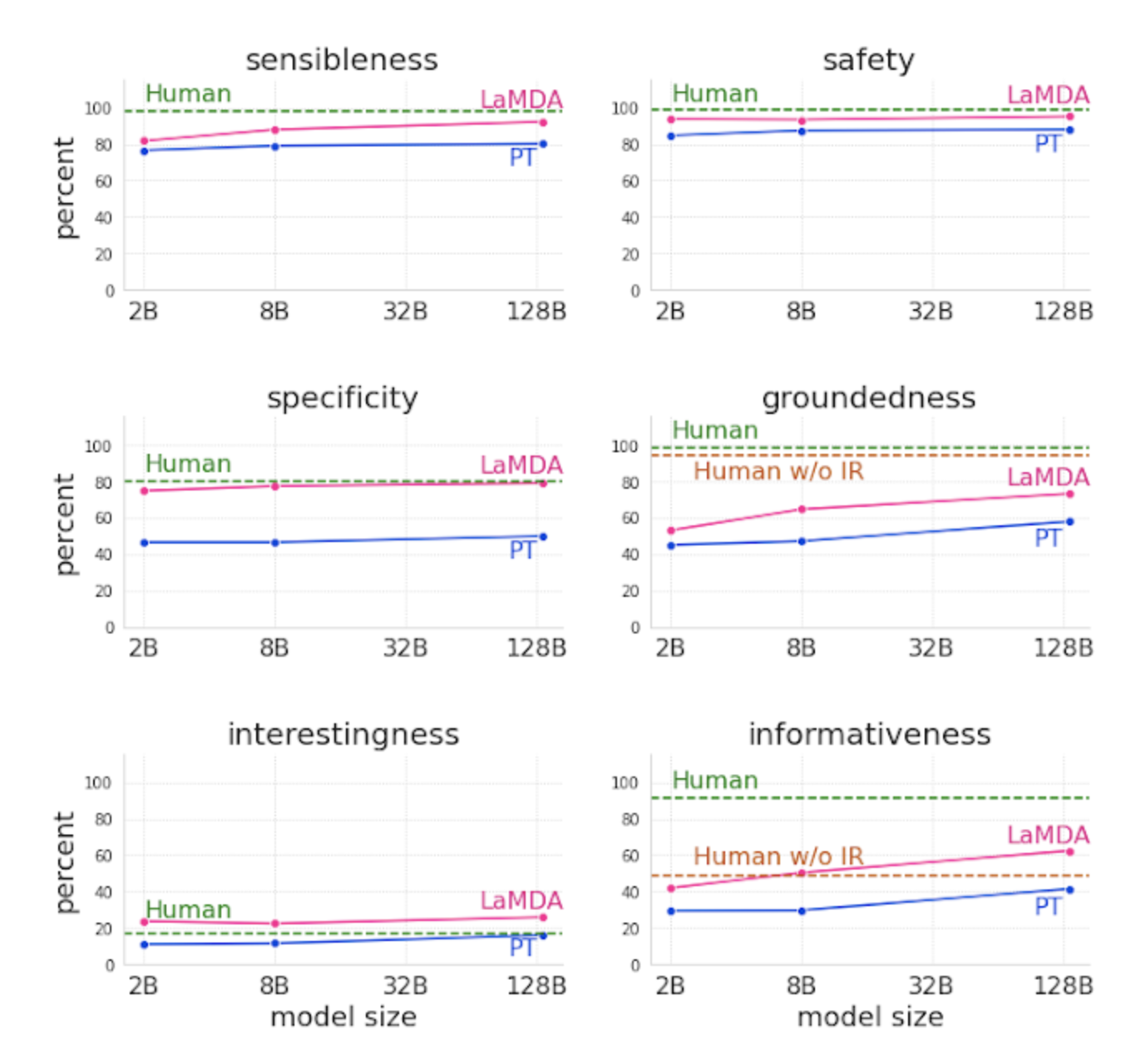

لقد تمكنوا حتى الآن من استنتاج ما يلي:

- تتحسن مقاييس الجودة مع عدد المعلمات.

- يتحسن الأمان مع الضبط الدقيق.

- يتحسن الإرساء مع زيادة حجم النموذج.

صورة من مدونة Google AI ، مارس 2022

صورة من مدونة Google AI ، مارس 2022كيف سيتم استخدام LaMDA؟

على الرغم من أنه لا يزال قيد التقدم بدون تاريخ إصدار ثابت ، فمن المتوقع أن يتم استخدام LaMDA في المستقبل لتحسين تجربة العملاء وتمكين روبوتات المحادثة من توفير محادثة أكثر شبهاً بالإنسان.

أيضًا ، يعد استخدام LaMDA للتنقل في البحث في محرك بحث Google احتمالًا حقيقيًا.

تداعيات LaMDA على تحسين محركات البحث

من خلال التركيز على النماذج اللغوية والمحادثة ، تقدم Google نظرة ثاقبة على رؤيتها لمستقبل البحث وتسلط الضوء على تحول في كيفية إعداد منتجاتها للتطور.

وهذا يعني في النهاية أنه قد يكون هناك تحول في سلوك البحث والطريقة التي يبحث بها المستخدمون عن المنتجات أو المعلومات.

تعمل Google باستمرار على تحسين فهم نية بحث المستخدمين لضمان حصولهم على النتائج الأكثر فائدة وذات الصلة في SERPs.

سيكون نموذج LaMDA بلا شك أداة رئيسية في فهم الأسئلة التي قد يطرحها الباحثون.

كل هذا يؤكد أيضًا على الحاجة إلى ضمان تحسين المحتوى للبشر بدلاً من محركات البحث.

التأكد من أن المحتوى محادثة ومكتوب مع أخذ جمهورك المستهدف في الاعتبار يعني أنه حتى مع تقدم Google ، لا يزال بإمكان المحتوى أداءً جيدًا.

من الضروري أيضًا أن بانتظام تحديث المحتوى الدائم للتأكد من أنه يتطور مع الزمن ويظل مناسبًا.

في مقال بعنوان إعادة التفكير في البحث: تحويل المتعطلين إلى خبراءشارك مهندسو البحث في Google كيف يتصورون أن التطورات في مجال الذكاء الاصطناعي مثل LaMDA ستعمل على تحسين “البحث كمحادثة مع الخبراء”.

شاركوا مثالاً حول سؤال البحث: “ما هي الفوائد الصحية ومخاطر النبيذ الأحمر؟”

حاليًا ، ستعرض Google قائمة بالإجابات ذات التعداد النقطي كإجابات على هذا السؤال.

ومع ذلك ، يقترحون أنه في المستقبل ، قد تكون الإجابة عبارة عن فقرة تشرح فوائد ومخاطر النبيذ الأحمر ، مع روابط لمعلومات المصدر.

لذلك ، فإن ضمان أن المحتوى مدعوم من مصادر الخبراء سيكون أكثر أهمية من أي وقت مضى إذا كان Google LaMDA يولد نتائج بحث في المستقبل.

التغلب على التحديات

كما هو الحال مع أي نموذج ذكاء اصطناعي ، هناك تحديات يجب التغلب عليها.

ال اثنين من التحديات الرئيسية التي يواجهها المهندسون مع Google LaMDA هي الأمان والرسو.

السلامة – تجنب التحيز

نظرًا لأنه يمكنك سحب الردود من أي مكان على الويب ، فقد يؤدي الإخراج إلى تضخيم التحيزات ، مما يعكس المفاهيم المشتركة عبر الإنترنت.

من المهم أن تذهب المسؤولية أولاً إلى Google LaMDA للتأكد من أنها لا تؤدي إلى نتائج غير متوقعة أو ضارة.

للمساعدة في التغلب على هذا ، فتحت Google الموارد المستخدمة لتحليل البيانات وتدريبها.

يسمح ذلك لمجموعات متنوعة بالمشاركة في إنشاء مجموعات البيانات المستخدمة لتدريب النموذج ، والمساعدة في تحديد أي تحيزات موجودة ، وتقليل مشاركة المعلومات الضارة أو المضللة.

قاعدة الأدلة

ليس من السهل التحقق من موثوقية الإجابات التي تنتجها نماذج الذكاء الاصطناعي ، حيث يتم جمع المصادر في جميع أنحاء الويب.

للتغلب على هذا التحدي ، يسمح الفريق للنموذج باستشارة مصادر خارجية متعددة ، بما في ذلك أنظمة استرجاع المعلومات وحتى الآلة الحاسبة ، لتقديم نتائج دقيقة.

يضمن مقياس Groundedness المشترك سابقًا أيضًا أن تستند الإجابات إلى مصادر معروفة. تتم مشاركة هذه المصادر للسماح للمستخدمين بالتحقق من صحة النتائج المقدمة وتجنب نشر معلومات كاذبة.

ما التالي لـ Google LaMDA؟

من الواضح أن Google نماذج الحوار المفتوح مثل LaMDA لها فوائد ومخاطر وهي ملتزمة بتحسين الأمان والرسو لضمان تجربة أكثر موثوقية وغير متحيزة.

تدريب نماذج LaMDA على بيانات مختلفة ، بما في ذلك الصور أو الفيديو ، هو شيء آخر قد نراه في المستقبل.

هذا يفتح القدرة على تصفح الويب أكثر باستخدام مطالبات المحادثة.

سوندار بيتشاي ، الرئيس التنفيذي لشركة Google قال لامدا“نعتقد أن قدرات المحادثة في LaMDA لديها القدرة على جعل المعلومات والحوسبة أكثر سهولة في الوصول إليها وسهولة في الاستخدام.”

على الرغم من عدم تأكيد تاريخ الإطلاق ، فلا شك في أن نماذج مثل LaMDA ستكون مستقبل Google.

المزيد من الموارد:

الصورة الرئيسية: Andrey Suslov / Shutterstock

#كيف #يعمل #نموذج #اللغة #لتطبيقات #الحوار

المصدر

تعليقات

إرسال تعليق